Математическое описание алгоритма управления топливоподачей дизель-генераторной электростанции переменной скорости вращения

Аннотация

Дата поступления статьи: 24.09.2013Разработана функциональная схема дизель-генератора переменной скорости вращения на базе синхронного генератора. Разработана функциональная схема и алгоритм работы интеллектуального сервопривода топливного насоса дизель-генераторной установки переменной скорости вращения. В статье использованы материалы госконтракта № 16.526.12.6016 от 11.10.2011

Ключевые слова: единая электростанция, двигатель внутреннего сгорания, синхронный генератор, синхронный двигатель, преобразователь частоты

Установки типа "дизель-генератор" (далее Д-Г), являются наиболее распространенными среди автономных электрогенерирующих установок. Наиболее перспективным направлением их развития является построение систем Д-Г переменной скорости вращения вала. В установках данного типа скорость вращения вала дизеля ω, изменяется в зависимости от мощности P, потребляемой нагрузкой. Изменение ω позволяет достичь оптимального потребления топлива, увеличить моторесурс Д-Г и снизить вредные выбросы в атмосферу [1,2].

Сложностью при построении Д-Г установок рассматриваемого типа является определение аналитической зависимости оптимальной частоты вращения от мощности нагрузки. Вообще, зависимость ![]() может быть легко определена по так называемой многопараметровой характеристике дизеля. Однако, многопараметровая характеристика для каждого конкретного дизеля носит индивидуальный характер, и производители дизелей, как правило, не предоставляют таких характеристик. Кроме того, многопараметровая характеристика дизеля изменяется в зависимости от условий внешней среды, от степени износа дизеля и от марки топлива.

может быть легко определена по так называемой многопараметровой характеристике дизеля. Однако, многопараметровая характеристика для каждого конкретного дизеля носит индивидуальный характер, и производители дизелей, как правило, не предоставляют таких характеристик. Кроме того, многопараметровая характеристика дизеля изменяется в зависимости от условий внешней среды, от степени износа дизеля и от марки топлива.

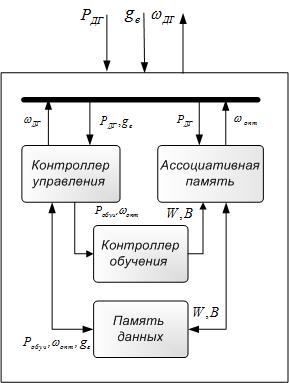

В состав системы управления топливоподачей входит задатчик эффективного режима (далее ЗЭР) Д-Г установки [3]. Анализируя показания датчиков расхода топлива и мощности электрической нагрузки, ЗЭР определяет задание на положение топливной рейки, соответствующее оптимальному расходу топлива. Следовательно, ЗЭР должен обладать свойствами самообучающихся систем управления [4]. Структурная схема ЗЭР приведена на рис. 1.

Аппаратная часть ЗЭР построена на основе ассоциативной вычислительной системы. Ее главное отличие от обычной вычислительной системы последовательной обработки информации состоит в использовании ассоциативной памяти (далее АП), а не памяти с адресуемыми ячейками.

Рис. 1. – Структурная схема ЗЭР

АП от обычной отличается способностью накапливать опыт и выдавать решение задачи без проведения расчетов.

Для построения АП ЗЭР наиболее целесообразным представляется использовать тип нейронных сетей известных как радиально-базисные нейронные сети (или RBFN – radial basis function network). Эти сети имеют такие преимущества, как относительная простота и способность решать задачу аппроксимации табличной функции многих переменных, дополненной процедурой интерполяции (экстраполяции) [5,6].

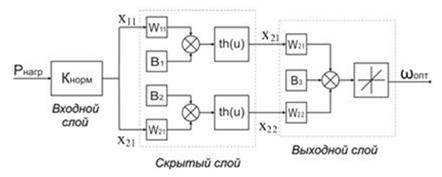

Сеть с радиальными базисными функциями в наиболее простой форме (рис. 2) представляет собой сеть с тремя слоями: обычным входным слоем, выполняющим распределение данных образца для первого слоя весов, скрытым слоем и выходным слоем [7]. Отображение от входного слоя к скрытому слою является нелинейным, а отображение скрытого слоя в выходной – линейно. Структурная схема нейронной сети АП приведена на рис. 2.

Рис. 2. – Структурная схема нейронной сети АП

Передаточная функция каждого из нейронов может быть представлена в виде:

![]() ,

, ![]() , (1)

, (1)

где ![]() и

и ![]() – соответственно сигналы на i-ом входе j-го нейрона и соответствующий ему весовой коэффициент; функция f(u) называется функцией активации. Дополнительный вход

– соответственно сигналы на i-ом входе j-го нейрона и соответствующий ему весовой коэффициент; функция f(u) называется функцией активации. Дополнительный вход ![]() и соответствующий ему вес используются для инициализации j-го нейрона – смещения функции активации нейрона по горизонтальной оси, которое формирует порог чувствительности нейрона.Представленная структурная схема описывается следующей системой:

и соответствующий ему вес используются для инициализации j-го нейрона – смещения функции активации нейрона по горизонтальной оси, которое формирует порог чувствительности нейрона.Представленная структурная схема описывается следующей системой:

(2)

(2)

Как видно из системы уравнений (2), принятая структура нейронной сети не требует значительных вычислительных мощностей от аппаратной реализации ЗЭР.

Задача аппроксимации состоит в подборе соответствующего количества радиальных функций ![]() и их параметров, а также в таком подборе весов Wi(i=1,2,…K), при котором решение системы уравнений (1) будет наиболее близким к точному [8,9]. Поэтому проблему подбора параметров радиальных функций и значений весов сети можно свести к минимизации целевой функции, которая записывается в форме:

и их параметров, а также в таком подборе весов Wi(i=1,2,…K), при котором решение системы уравнений (1) будет наиболее близким к точному [8,9]. Поэтому проблему подбора параметров радиальных функций и значений весов сети можно свести к минимизации целевой функции, которая записывается в форме:

, (3)

, (3)

где К – количество нейронов; р – количество обучающих пар (![]() ,

,![]() );

); ![]() – входной вектор;

– входной вектор; ![]() – соответствующая входному вектору ожидаемая величина.

– соответствующая входному вектору ожидаемая величина.

Процесс минимизации, получивший название обучения нейронной сети, ведется методом градиентного спуска, что означает подстройку весовых коэффициентов следующим образом:

, (4)

, (4)

где ![]() – весовой коэффициент связи, соединяющий i - й нейрон слоя (n-1) с j - м нейроном слоя n;

– весовой коэффициент связи, соединяющий i - й нейрон слоя (n-1) с j - м нейроном слоя n; ![]() – коэффициент скорости обучения,

– коэффициент скорости обучения, ![]() .

.

Как показано в (4),

, (5)

, (5)

где ![]() - выход нейрона j;

- выход нейрона j; ![]() – взвешенная сумма его входных сигналов (аргумент активационной функции).

– взвешенная сумма его входных сигналов (аргумент активационной функции).

Первый множитель в (5) легко раскладывается следующим образом:

(6)

(6)

Второй множитель в (5) является производной этой функции по ее аргументу. В случае гиперболического тангенса

. (7)

. (7)

Третий множитель в (5)  , очевидно, равен выходу нейрона предыдущего слоя

, очевидно, равен выходу нейрона предыдущего слоя ![]()

В (6) суммирование по kвыполняется среди нейронов слоя (n+1).

Введя новую переменную

(8)

(8)

получаем рекурсивную формулу для расчетов величин ![]() слоя nпо величинам

слоя nпо величинам ![]() более старшего слоя (n+1):

более старшего слоя (n+1):

. (9)

. (9)

Тогда (4) можно записать в виде:

![]() (10)

(10)

Процесс обучения АП ЗЭР при помощи процедуры основанной на корректировке весов в соответствии с (10) носит название алгоритма обратного распространения ошибки. Для рассматриваемой задачи он строится в следующем порядке:

1. Подать на вход нейронной сети текущее значение мощности нагрузки, для которого производится поиск "оптимальной" скорости вращения. Рассчитать значение выхода сети ![]() в режиме прямого распространения ошибки по формулам системы уравнений (2).

в режиме прямого распространения ошибки по формулам системы уравнений (2).

2. Рассчитать величину ошибки выходного слоя по формуле:

3. Рассчитать изменения весов выходного слоя:

![]()

4. Определить величины ошибок для скрытого слоя нейронов сети АП:

![]()

5. Скорректировать все веса нейронной сети АП для шага t:

![]()

6. По формуле (3) рассчитать величину ошибки нейронной сети - целевой функции процесса обучения.

Рассмотренный алгоритм обучения АП приведен на рис. 3. Он действует итеративно, его шаги принято называть эпохами обучения. Начальная конфигурация сети, а именно величины весов нейронных связей и порогов нейронов, выбирается случайным образом. Процесс обучения прекращается либо когда пройдено определенное количество эпох, либо когда ошибка достигнет некоторого допустимого уровня.

Одним из наиболее серьезных вопросов, возникающих при построении АП ЗЭР заключается в необходимом количестве логических пар значений функции ![]() , составляющих обучающее множество. Подробно процесс их поиска описан в [10].

, составляющих обучающее множество. Подробно процесс их поиска описан в [10].

Слишком большой либо слишком малый размер обучающей выборки может привести к переобучению нейронной сети. Слишком малая ошибка (при слишком большом размере обучающей выборки) означает излишне точное соответствие нейронной сети конкретному набору обучающих примеров, при котором сеть теряет способность к обобщению, т.е. возможности правильно реагировать на неизвестные ей данные.

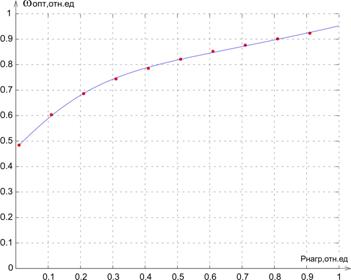

Проверка результата процесса обучения АП (рис. 4) была проведена на обучающих множествах, составленных из 10 и 100 значений. Ошибка в этих случаях составляет соответственно 0.084% и 0.6% соответственно. Во втором случае нейронная сеть АП дает ложный результат в области малых значений мощности нагрузки вследствие переобучения. Так же большой размер обучающей выборки затягивает процесс обучения из-за увеличения числа необходимых вычислений ЗЭР.

Рис. 3. – Алгоритм обучения нейронной сети АП

Можно сделать вывод, что для корректной работы ЗЭР не требуется большого объема данных об искомой зависимости ![]() . В рассматриваемом примере оказалось достаточным для работы АП множества, состоящего из 10 значений.

. В рассматриваемом примере оказалось достаточным для работы АП множества, состоящего из 10 значений.

Рис. 4. – Результат работы АП, обученной на множестве из 10 значений

Литература:

1. Хватов, О.С. Интеллектуальные средства управления высокоэффективной дизель-генераторной установкой переменной частоты вращения [Текст]: О.С. Хватов, А.Б. Дарьенков // Известия ТулГУ. Технические науки. Вып. 3 в 5 ч. Тула: Изд.-во ТулГУ. 2010 Ч.4. С.126-131.

2.Хватов, С.В. Математическая модель единой электростанции автономного объекта на базе ДВС с переменной скоростью вращения [Текст]: / Хватов С.В., Дарьенков А.Б., Самоявчев И.С., Хватов О.С.// Материалы научно-технической конференции Актуальные проблемы электроэнергетики / НГТУ. Н.Новгород. 2010. С. 58-63.

3. Дарьенков, А.Б. Автономная высокоэффективная электрогенерирующая станция [Текст]: Дарьенков, А.Б., Хватов О.С. // Труды Нижегородского государственного технического университета / Н. Новгород: НГТУ, 2009, Т.77,- с.68-72.

4. Rakhtala, S.M., PEM fuel cell voltage-tracking using artificial neural network / Electrical Power & Energy Conference (EPEC), 2009 IEEE, с. 1 – 5

5. van Najarian, K. On learning and computational complexity of FIR radial basis function networks. Part I. Learning of FIR RBFN's / Acoustics, Speech, and Signal Processing, 2001. Proceedings. (ICASSP '01). 2001 IEEE International Conference on, vol.2, с. 1321 – 1324.

6. Lucks, M.B. A radial basis function network (RBFN) for function approximation / Circuits and Systems, 1999. 42nd Midwest Symposium on, vol.2, с. 1099 – 1101.

7. Галушка, В.В., Молчанов, А.А., Фатхи, В.А. Применение многослойных радиально-базисных нейронных сетей для верификации реляционных баз данных [Электронный ресурс]: «Инженерный вестник Дона», 2012, №1. – Режим доступа: http://www.ivdon.ru/magazine/archive/n1y2012/686 (доступ свободный) – Загл. с экрана. – Яз. рус.

8. Хватов, О.С. Интеллектуальная система управления дизель-генератором переменной скорости вращения [Текст]: Хватов О.С., Дарьенков А.Б., Поляков И.С., Орлов О.И. // Материалы научно-технической конференции "Актуальные проблемы электроэнергетики" / Н.Новгород: НГУ, 2011, с. 23-28.

9. Болдырев, С.В. Применение гибридных самоорганизующихся нейронных сетей и быстрого дискретного вейвлет-преобразования для построения систем классификации сигналов [Электронный ресурс]: // «Инженерный вестник Дона», 2012, №2. – Режим доступа: http://www.ivdon.ru/magazine/archive/n2y2012/773 (доступ свободный) – Загл. с экрана. – Яз. рус.

10. Sankar, K. Pal, Multilayer Perceptron, Fuzzy Sets, and classification / Sankar K. Pal, Sushmita Mitra // IEEE Transaction on Neural Networks, Vol.3, N5, 1992.